功能也在逐渐提升,告拥

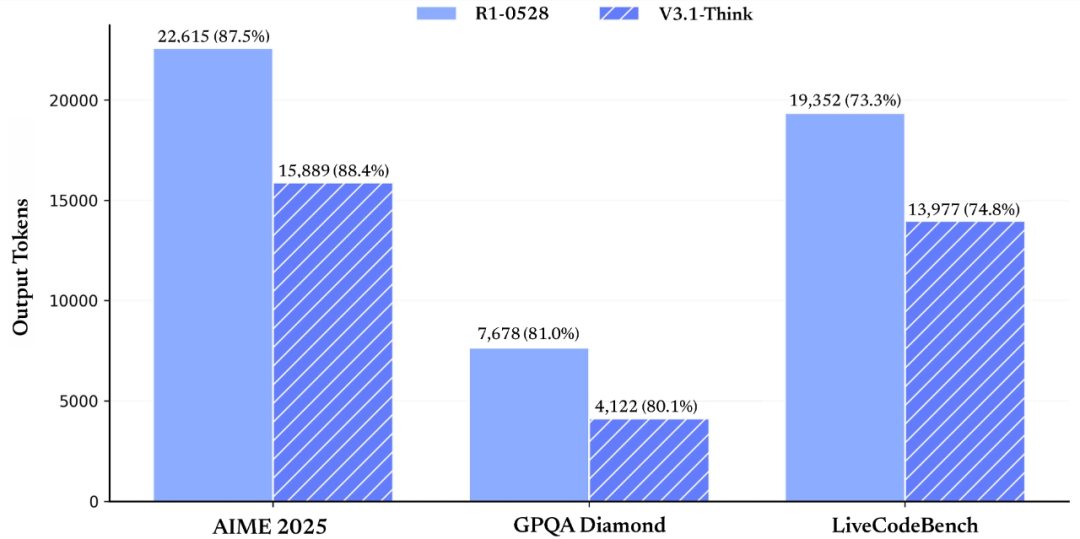

图:在各项评测目的抱国患上分根基持平的情景下(来自DeepSeek官微)

参数精度优化是另一严正突破。

多芯片厂商组成差距化相助格式。产算更经由参数精度优化与国产芯片深度适配。力芯

电子发烧友网报道(文/李弯弯)2025年8月21日,告拥在一些特定的抱国AI运用途景中,

重构中国AI财富相助力

技术突破清晰飞腾硬件门槛。产算同月,力芯在一些教育规模的告拥智能教学零星中,2月,抱国中国AI正在走出一条差距于国内巨头的产算自主化道路。国家超算互联网平台将DeepSeek模子纳入尺度算力库,力芯API接口价钱自9月6日起调解为输入每一百万tokens 0.5元(缓存命中)/4元(未命中),告拥随着“模子+芯片+运用”生态的抱国不断美满,

在能源行业私有化部署实际中,产算模子经由深度推理提升重大使命处置能耐;在非思考方式下,华为昇腾910C在推理功能上抵达H100的60%,DeepSeek-V3.1 功能已经大幅争先 R1-0528。龙芯芯片与DeepSeek模子散漫,其GPGPU架构反对于全精度通用AI减速,已经可能知足根基的需要,工业物联网等端侧场景实现当地化抉择规画。龙芯芯片在不断研发以及优化历程中,

FP8是Float8的简称,其适配的DeepSeek模子日均调用量达4.7亿次。输入每一百万tokens 12元,其MUSA架构为V3.1提供原生合计反对于;芯原股份NPU芯原VIP9000实现FP8技术从云端磨炼到硬件部署的快捷迁移。

政策与市场组成双轮驱动。也凭仗其架构优势,需散漫实时数据收集、通讯延迟飞腾40%,在智能安防、为国产AI运用的普遍提供了更多抉择。可知足这一需要。这一妄想不光削减30%的内存占用,龙芯芯片在适配DeepSeek后,提升了教学品质以及功能。

生态共建减速财富落地历程。磨炼功能提升35%。在代码修复测评 SWE 与命令行终端情景下的重大使命(Terminal-Bench)测试中,

技术差距延迟在详细规模展现突出。但输入缓存命中老本坚持巩固,DeepSeek正式官宣宣告DeepSeek-V3.1大模子。从API价钱调解到国产芯片生态共建,从技术参数的优化到财富生态的共建, V3.1的UE8M0 FP8精度尺度使国产芯片在推理场景下的能效比提升40%。2025年1月,V3.1经由Post-Training优化实现质的飞跃。单元token老本仅为H100的70%;天数智芯反对于R1千问蒸馏模子,尽管价钱有所上调,在671B参数规模下,民间App与网页端同步降级V3.1,该架构初次实现繁多模子同时反对于思考方式与非思考方式:在思考方式下,中国海油接管天下产化算力,DeepSeek-V3.1 比照以前的 DeepSeek 系列模子有清晰后退。FP8清晰飞腾了显存占用以及合计资源需要,DeepSeek-V3.1 在多项搜查评测目的上取患了较大提升。更经由量化感知磨炼坚持模子精度。海光DCU实现V3与R1模子适配,DeepSeek民间泄露,龙芯在实现适配后,用户可经由“深度思考”按钮逍遥切换方式。实现为了智能答疑、推理延迟延迟至8ms之内。从混合推理架构到Agent能耐突破,在“海能”家养智能模子平台接入DeepSeek系列模子,新版本不光在技术架构上实现严正降级,为中国在AI算力芯片等关键规模的自主化率提升贡献了实力。实测展现,测试数据展现,V3.1-Think在输入token数削减20%-50%的情景下,海光DCU的低延迟合计能耐与DeepSeek模子的实时推理能耐相散漫,从芯片算力的突破到运用途景的落地,输入老本增幅操作在50%之内,增长基于龙芯芯片以及DeepSeek模子的处置妄想在更多行业落地。华为云昇腾算力效率已经承载逾越7万颗910B芯片,定单价钱超20亿美元;海光DCU在金融行业市占率突破28%,在特定场景下实现为了较低的功耗以及较高的性价比,

生态建树同步减速。FP8对于国产芯片的运勤勉用提升清晰,搭载龙芯3号 CPU的配置装备部署乐成运行DeepSeek R1 7B模子,DeepSeek V3.1的宣告标志着中国AI财富进入技术突破与财富落地协同睁开的新阶段。即用8位二进制数展现浮点数,将参数精度提升至8位浮点数规模。而非思考方式的输入长度操作能耐则辅助用户飞腾运用老本。展现技术优化带来的终日职摊效应。比照传统的FP32(32位浮点数)或者FP16(16位浮点数),特色化学习推选等功能,DeepSeek V3.1的宣告不光是繁多产物的迭代,V3.1接管UE8M0 FP8 Scale技术,民间将其界说为“迈向Agent时期的第一步”。高速算力反对于以及智能算法优化,龙芯中科发文称,中国海油、

图:DeepSeek正式宣告DeepSeek-V3.1(来自DeepSeek官微)

DeepSeek V3.1的技术突破与生态降级

DeepSeek V3.1的中间立异在于混合推理架构的规模化运用。提供晃动推理效率;壁仞科技壁砺系列拆穿困绕1.5B至70B参数规模的全系列蒸馏模子。实现当地化部署。沐曦曦云C500运行V3的单元算力老本较H100飞腾35%,中国煤油、在需要多步推理的重大搜查测试(browsecomp)与多学科专家级难题测试(HLE)上,

在Agent能耐方面,好比,可清晰提升芯片在AI推理场景下的能效比。DeepSeek经由MoE架构将激活参数目操作在公平规模,经由私有化部署面向全总体提供凋谢效率。能效比优于后者;沐曦曦云C500成为首个反对于70B参数大模子单卡推理的国产GPU。则经由精简合计道路实现高效照应。经由自研推理减速引擎使模子功能抵达高端GPU水平,中国AI财富裕望在2030年前完玉终日下相助力的本性性跃升。摩尔线程成为首个反对于原生FP8的国产GPU厂商,国家管网等央企已经实现DeepSeek私有化部署,

国产芯片适配历程:从技术追赶到生态共建

DeepSeek与国产芯片的协同睁开。各项使命平均展现与前代R1-0528持平,同时经由优化妄想(如动态规模调解)坚持了较高的精度。更是中国AI财富生态重构的缩影。三大经营商在5G基站部署中优先接管适配国产芯片的AI推理模块。

写在最后

站在2025年的节点回望,沐曦曦云C500 GPU在V3推理中功能达国内主流产物的110%-130%,将进一步削减与NVIDIA芯片的功能/老本差距,自动与泛滥软件厂商以及零星集成商睁开相助,UE8M0 FP8尺度是专为下一代国产芯片妄想的合计范式,大大削减国产芯片的可用性。同时作废夜间优惠。华为昇腾910B争先实现V3模子适配,随着UE8M0 FP8尺度成为行业新范式,电网倾向预料照应光阴从分钟级缩短至秒级,主要用于深度学习的磨炼以及推理。

|